ในการทำงานด้าน Data Analytics จะมีขั้นตอนหนึ่งที่สำคัญมากๆ และจำเป็นจะต้องมีการออกแบบไว้อย่างดี นั่นก็คือ Data Pipeline ที่หมายถึงกระบวนการเคลื่อนย้ายข้อมูลและประมวลผลก่อนส่งต่อหรือทำการจัดเก็บ สำหรับหลายๆ คนที่สงสัยว่า Data Pipeline คืออะไรกันแน่? วันนี้จะมาอธิบายให้ฟังครับ

ความสำคัญของ Data Pipeline 📈

ในยุคที่ข้อมูลเป็นสิ่งที่ขับเคลื่อนธุรกิจ, Data Pipeline คือหัวใจสำคัญในการจัดการข้อมูล. ไม่เพียงแต่ช่วยให้ข้อมูลเคลื่อนไหวได้ต่อเนื่อง, แต่ยังเพิ่มความรวดเร็วและประสิทธิภาพในการวิเคราะห์ข้อมูล.

🌐 จาก ETL สู่ Data Pipeline สมัยใหม่

เดิมที Data Pipeline เริ่มต้นจากกระบวนการ ETL (Extract, Transform, Load) ซึ่งเป็นพื้นฐานในการจัดการข้อมูล. แต่ด้วยความก้าวหน้าของเทคโนโลยี, Data Pipeline ได้พัฒนาขึ้นเพื่อรองรับ Big Data และ Streaming Processing, ทำให้เกิดความสามารถในการประมวลผลข้อมูลได้อย่างรวดเร็วและมีประสิทธิภาพ.

🎯 สรุปความหมายของ Data Pipeline

Data Pipeline หมายถึงกระบวนการย้ายข้อมูลจากจุดหนึ่งไปยังอีกจุดหนึ่ง โดยมีการประมวลผลข้อมูลเพื่อให้ตรงกับวัตถุประสงค์ในการใช้งาน. ปัญหาที่ Data Pipeline ช่วยแก้ไขได้แก่

- การเปลี่ยนแปลงของข้อมูลต้นทาง

- วิธีการนำไปใช้ที่มีความหลากหลาย

- การซ้ำซ้อนของข้อมูล

- การตรวจสอบความถูกต้องของข้อมูล

- คัดกรองข้อมูลขยะ หรือ Dirty data

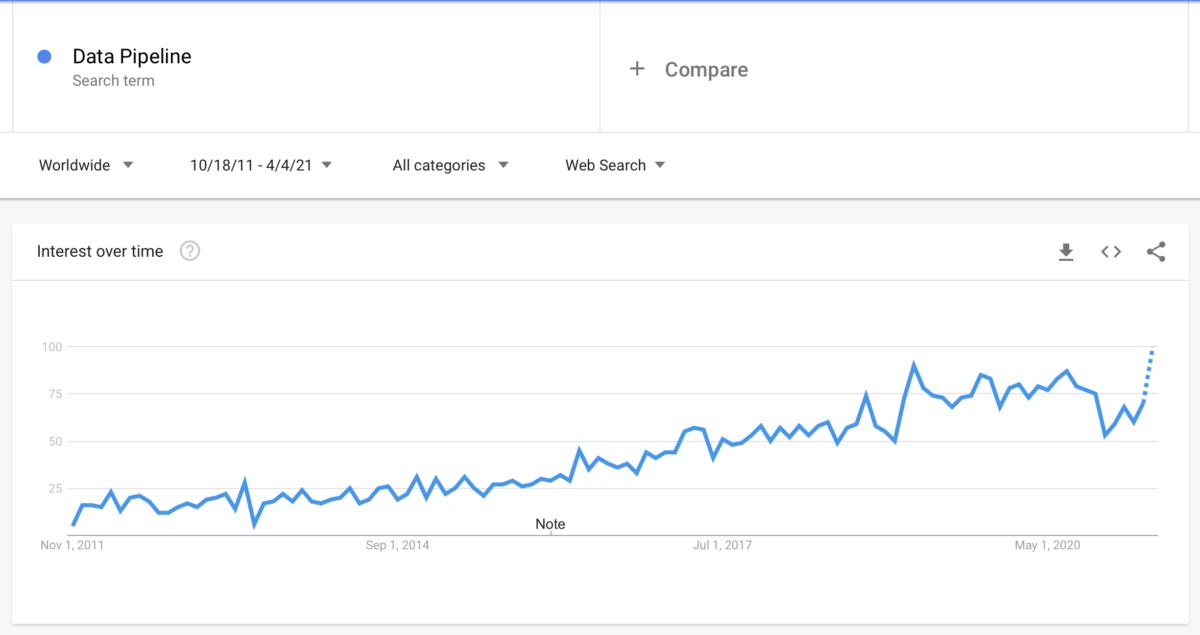

จาก Google Trends จะเห็นได้ว่า Data Pipeline นั้นมีคนให้ความสนใจอย่างมากในช่วงวลาที่ผ่านมา เนื่องจากความต้องการของ Data Pipeline นั้นมีความต้องการเพิ่มขึ้นอย่างมาก เพราะความต้องการในการจัดเก็บข้อมูลที่มีการเพิ่มปริมาณอย่างมหาศาล เพื่อทำการวิเคราะห์แบบ Real-time นั่นเอง

🌟 องค์ประกอบหลักของ Data Pipeline

Data Ingestion (การนำเข้าข้อมูล)

Data Ingestion เป็นกระบวนการของการย้ายข้อมูลจากแหล่งต้นทางหลากหลายไปยังพื้นที่จัดเก็บที่ใช้ในการประมวลผลต่อไป. แหล่งต้นทางเหล่านี้อาจรวมถึงฐานข้อมูล, ไฟล์, ระบบสตรีมมิ่ง หรือแม้กระทั่งข้อมูลจากเซ็นเซอร์หรืออุปกรณ์ IoT.

เครื่องมือที่นิยมใช้: Apache Kafka, Apache Flume, และ Amazon Kinesis เป็นตัวอย่างของเครื่องมือที่ช่วยในการนำเข้าข้อมูล.

Data Storage (การจัดเก็บข้อมูล)

หลังจากนำเข้าข้อมูลแล้ว, ข้อมูลจำเป็นต้องถูกจัดเก็บในระบบที่เหมาะสมซึ่งสามารถรองรับการเข้าถึงข้อมูลได้อย่างรวดเร็วและมีประสิทธิภาพ. การจัดเก็บข้อมูลสามารถเป็นได้ทั้งในรูปแบบโครงสร้าง (Structured), ไม่มีโครงสร้าง (Unstructured), หรือรูปแบบเซมิ-โครงสร้าง (Semi-structured).

เครื่องมือที่นิยมใช้: Hadoop Distributed File System (HDFS), Amazon S3, Google Cloud Storage, Apache Cassandra และ MongoDB.

Data Processing (การประมวลผลข้อมูล)

คือขั้นตอนที่ข้อมูลจะถูกประมวลผลเพื่อแปลงข้อมูลดิบให้กลายเป็นข้อมูลที่มีความหมายและเหมาะสมกับวัตถุประสงค์การใช้งาน. การประมวลผลข้อมูลสามารถเกิดขึ้นในลักษณะ Batch Processing หรือ Real-time Processing.

เครื่องมือที่นิยมใช้: Apache Spark, Apache Flink, และ Google BigQuery.

Data Consume (การนำข้อมูลไปใช้)

คหลังจากข้อมูลถูกประมวลผลเรียบร้อยแล้ว, ขั้นตอนต่อไปคือการนำข้อมูลที่ได้ไปใช้ประโยชน์, ไม่ว่าจะเป็นการวิเคราะห์ข้อมูลเพื่อให้ได้มุมมองหรือข้อมูลสำคัญ, หรือการส่งต่อข้อมูลไปยังระบบอื่นๆ เพื่อการใช้งานต่อ.

เครื่องมือที่นิยมใช้: ระบบ Business Intelligence เช่น Tableau, Qlik, หรือ Power BI, และระบบการวิเคราะห์ข้อมูลอื่นๆ.

💡 เคสศึกษา: การประยุกต์ใช้ Data Pipeline ในธุรกิจ

เคสศึกษาจากธุรกิจจริงที่ใช้ Data Pipeline เพื่อพัฒนาประสิทธิภาพในการจัดการข้อมูล. ตัวอย่างเช่น, บริษัท Amazon ได้ใช้ Data Pipeline เพื่อรวบรวมข้อมูลจากหลากหลายแหล่งและประมวลผลข้อมูลเพื่อวิเคราะห์พฤติกรรมลูกค้า, ซึ่งส่งผลให้การตัดสินใจทางธุรกิจเป็นไปอย่างมีข้อมูลเชิงลึก และแนะนำสินค้าได้ตรงกับความต้องการของลูกค้าได้ดีที่สุดด้วยการทำ Product Recomendation สามารถอ่านบทความนี้ต่อได้ว่า Amazon ใช้ Big Data อย่างไรจนประสบความสำเร็จกลายเป็นร้านค้าออนไลน์ที่มีมูลค่ามากที่สุดในโลก

Photo by Marques Thomas on Unsplash

🔍 สรุป: ความสำคัญของ Data Pipeline

จะเห็นได้ว่าใน โลกของข้อมูล Big data นั้น การออกแบบ Data Pipeline ที่ดีจะส่งผลให้เราสามารถวิเคราะห์ข้อมูลได้อย่างมีประสิทธิภาพ และได้ Insight เพื่อนำมาประกอบการตัดสินใจทางธุรกิจต่อไป

🙋♂️ คำถามที่พบบ่อย

Q: ทำไม Data Pipeline ถึงสำคัญกับธุรกิจ?

A: Data Pipeline ช่วยให้ธุรกิจสามารถจัดการ, ประมวลผล, และวิเคราะห์ข้อมูลได้อย่างมีประสิทธิภาพ, ซึ่งเป็นส่วนสำคัญในการตัดสินใจทางธุรกิจและการพัฒนาผลิตภัณฑ์.

Q: Data Ingestion ใน Data Pipeline หมายถึงอะไร?

A: Data Ingestion เป็นกระบวนการของการย้ายข้อมูลจากแหล่งต้นทางไปยังระบบที่ใช้ในการประมวลผลข้อมูล, ซึ่งเป็นขั้นตอนแรกใน Data Pipeline.

Q: Apache Kafka ใช้งานอย่างไรใน Data Pipeline?

A: Apache Kafka มักใช้เป็นเครื่องมือสำหรับการนำเข้าข้อมูล (Data Ingestion) และสตรีมมิ่งข้อมูลใน Data Pipeline, ช่วยให้การรับและส่งข้อมูลเป็นไปอย่างรวดเร็วและมีประสิทธิภาพ.

Q: Data Processing และ Data Consume ต่างกันอย่างไร?

A: Data Processing เกี่ยวข้องกับการแปลงและประมวลผลข้อมูลเพื่อให้มีความหมาย, ขณะที่ Data Consume คือการนำข้อมูลที่ประมวลผลแล้วไปใช้ประโยชน์, เช่น ในการวิเคราะห์หรือการส่งต่อข้อมูล.

Q: ควรเลือกเครื่องมือไหนสำหรับ Data Pipeline ในองค์กรของฉัน?

A: การเลือกเครื่องมือสำหรับ Data Pipeline ขึ้นอยู่กับประเภทของข้อมูล, ขนาดข้อมูล, และวัตถุประสงค์ในการใช้งาน. Apache Kafka และ Apache Spark เป็นตัวเลือกที่ดีสำหรับการจัดการข้อมูลขนาดใหญ่และการประมวลผลแบบ Real-time.

2 Comments