สวัสดีครับ วันนี้เรามาพูดถึงเรื่องที่กำลังมาแรงในวงการ AI กันหน่อยดีกว่า นั่นก็คือ Ollama แพลตฟอร์มจัดการ LLM แบบออฟไลน์ที่น่าจับตามองเป็นอย่างยิ่ง

Ollama เป็นแพลตฟอร์มใหม่ที่พัฒนาขึ้นมาเพื่อให้นักพัฒนา นักวิจัย และองค์กรต่างๆ สามารถใช้งาน LLM บนเครื่องคอมพิวเตอร์ของตัวเองได้โดยตรง โดยไม่ต้องพึ่งพาระบบคลาวด์ จุดเด่นของ Ollama คือการให้ความสำคัญกับความปลอดภัยและความเป็นส่วนตัวสูง เหมาะสำหรับงานที่ต้องการความปลอดภัยของข้อมูลเป็นพิเศษครับ

ทำไม Ollama ถึงน่าสนใจ?

ผมขอสรุปจุดเด่นของ Ollama ให้เข้าใจง่ายๆ ดังนี้ครับ:

- รันบนเครื่องตัวเอง ไม่ต้องพึ่งคลาวด์: Ollama ช่วยให้เราสามารถใช้งาน LLM บนเครื่องคอมพิวเตอร์ของเราเองได้ ไม่ต้องส่งข้อมูลไปประมวลผลบนคลาวด์ ทำให้มั่นใจได้ว่าข้อมูลของเราจะไม่รั่วไหลไปไหน

- ประหยัดค่าใช้จ่าย: เมื่อไม่ต้องใช้บริการคลาวด์ ก็ไม่ต้องจ่ายค่าบริการรายเดือนหรือรายปีให้กับผู้ให้บริการคลาวด์ ประหยัดงบประมาณไปได้เยอะเลยครับ

- ปรับแต่งได้ตามใจชอบ: Ollama ออกแบบมาให้ยืดหยุ่น เราสามารถปรับแต่งโมเดล LLM ให้เหมาะกับงานของเราได้อย่างอิสระ

- รองรับการขยายตัว: แม้จะทำงานบนเครื่องเราเอง แต่ Ollama ก็รองรับการทำงานกับข้อมูลขนาดใหญ่ได้ดี สามารถปรับขนาดตามปริมาณงานได้อย่างมีประสิทธิภาพ

💡 ในความเห็นของผม Ollama น่าจะเป็นทางเลือกที่ดีสำหรับองค์กรที่ต้องการใช้งาน AI แต่กังวลเรื่องความปลอดภัยของข้อมูล โดยเฉพาะอย่างยิ่งในอุตสาหกรรมที่มีกฎระเบียบเข้มงวด เช่น การเงิน การแพทย์ หรือหน่วยงานรัฐบาล

จุดเด่นสำคัญของ Ollama

มาดูกันว่า Ollama มีจุดเด่นอะไรบ้างที่ทำให้มันแตกต่างจากแพลตฟอร์ม LLM อื่นๆ

1. การติดตั้งและใช้งานบนเครื่องตัวเอง (Local Deployment)

จุดเด่นที่สุดของ Ollama คือการที่เราสามารถติดตั้งและใช้งานมันบนเครื่องคอมพิวเตอร์ของเราเองได้ ไม่ต้องพึ่งพาระบบคลาวด์เลย ซึ่งแตกต่างจาก โมเดลภาษาขนาดใหญ่ ทั่วไปที่มักจะทำงานบนคลาวด์

การทำงานแบบนี้ทำให้เรามีอำนาจควบคุมข้อมูลของเราอย่างเต็มที่ ไม่ต้องกังวลว่าข้อมูลจะรั่วไหลหรือถูกนำไปใช้โดยไม่ได้รับอนุญาต เหมาะมากสำหรับองค์กรที่ต้องการความปลอดภัยสูงๆ ครับ

2. ไม่ต้องพึ่งทรัพยากรคลาวด์ (Cloud)

ปัญหาใหญ่ของการใช้ AI ในปัจจุบันคือค่าใช้จ่ายที่สูงมากในการใช้บริการคลาวด์ แต่ Ollama ช่วยแก้ปัญหานี้ได้ เพราะมันใช้ทรัพยากรของเครื่องเราเองทั้งหมด

นอกจากจะประหยัดค่าใช้จ่ายแล้ว ยังช่วยลดปัญหาความล่าช้าในการส่งข้อมูลไปมาระหว่างเครื่องเรากับเซิร์ฟเวอร์คลาวด์ด้วย ทำให้การทำงานเร็วขึ้นและตอบสนองได้แบบเรียลไทม์มากขึ้นครับ

3. ความยืดหยุ่นและการปรับแต่ง

Ollama ออกแบบมาให้ยืดหยุ่นสูงมาก เราสามารถปรับแต่งโมเดล LLM ให้เหมาะกับงานเฉพาะทางของเราได้ ไม่ว่าจะเป็นงานประมวลผลภาษา ระบบตอบคำถามอัตโนมัติ หรือระบบแนะนำสินค้า

ที่สำคัญคือ Ollama สามารถทำงานร่วมกับเครื่องมือและระบบที่เรามีอยู่แล้วได้อย่างง่ายดาย ไม่ต้องเปลี่ยนแปลงระบบทั้งหมด แค่เพิ่ม Ollama เข้าไปก็สามารถเพิ่มความสามารถด้าน AI ให้กับระบบเดิมได้เลย

วิธีเริ่มต้นใช้งาน Ollama

ถ้าสนใจจะลองใช้ Ollama ผมขอแนะนำวิธีเริ่มต้นง่ายๆ ดังนี้ครับ:

- Download Ollama: เข้าไป Download ได้ที่เว็บของ Ollama ได้เลยครับ https://ollama.com/download ตอนนี้รองรับทั้ง Mac, Windows, Linux เลยครับ

- ติดตั้ง Ollama: เมื่อ Download เสร็จก็สามารถติดตั้งได้เลยครับ

- จากนั้นเปิด Terminal หรือ Command Line

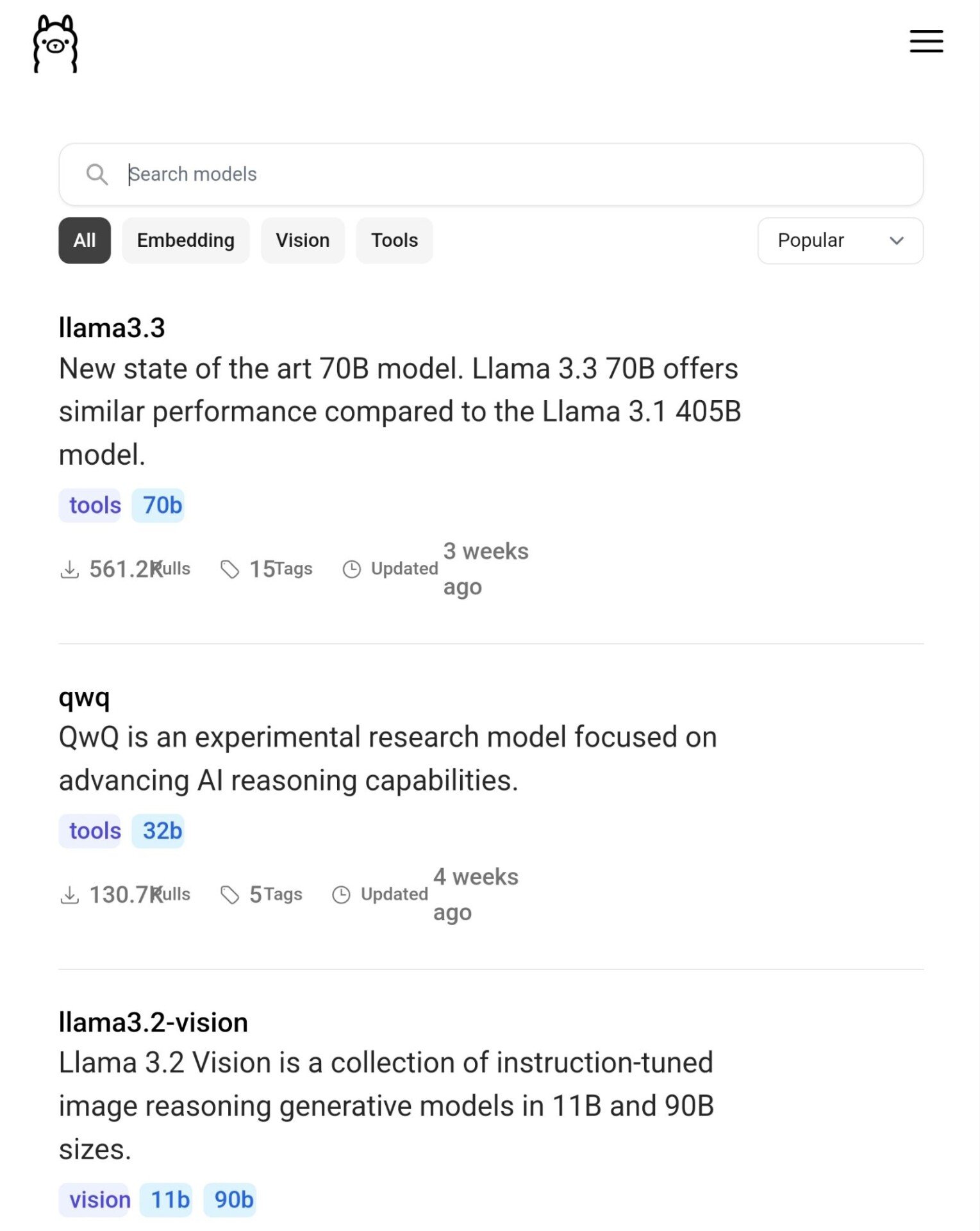

- Download model ที่ต้องการจากหน้า https://ollama.com/library สามารถพิมพ์คำสั่ง เพื่อ download model มาใช้บน Ollama ได้ครับ เช่น

ollama run llama3.2

- เมื่อ Download เสร็จแล้ว เราสามารถเริ่มใช้ Ollama ได้โดยพิมพ์ Prompt ผ่าน Command Line ได้เลยครับ

- ปรับแต่งตามการใช้งาน: ขั้นตอนนี้ขึ้นอยู่กับว่าเราจะใช้ Ollama ทำอะไร อาจต้องแก้ไขสคริปต์นิดหน่อยตามความเหมาะสม

- เชื่อมต่อกับระบบของเรา: ศึกษาเอกสารประกอบการใช้งานเพื่อดูวิธีเชื่อมต่อ Ollama กับระบบที่มีอยู่ Ollama มี API และสคริปต์ต่างๆ ให้ใช้งาน ทำให้การผสานเข้ากับระบบเดิมทำได้ไม่ยากครับ

💡 Tips: ถ้าใครไม่คุ้นเคยกับการใช้ Command Line อาจจะงงๆ ตอนแรก แต่ไม่ต้องกลัวนะครับ ลองทำตามทีละขั้นตอน ถ้าติดปัญหาตรงไหนก็สามารถหาข้อมูลเพิ่มเติมได้จากเอกสารประกอบการใช้งานของ Ollama หรือถามในชุมชนนักพัฒนาได้ครับ หรือจะลองใช้ร่วมกับ Web Interface อย่าง Open WebUI ได้ครับ

ข้อควรพิจารณาในการใช้งาน Ollama

แม้ว่า Ollama จะมีข้อดีหลายอย่าง แต่ก็มีบางประเด็นที่เราควรพิจารณาก่อนตัดสินใจใช้งานครับ:

- ต้องการทรัพยากรเครื่องที่แรงพอสมควร: การรัน LLM บนเครื่องตัวเองต้องใช้ทรัพยากรเยอะพอสมควร โดยเฉพาะ RAM และ GPU ถ้าเครื่องไม่แรงพออาจจะทำงานได้ช้าหรือไม่เสถียร

- ต้องอัปเดตโมเดลเอง: เมื่อมีโมเดล LLM ใหม่ๆ ออกมา เราต้องอัปเดตเองซึ่งอาจจะยุ่งยากกว่าการใช้บริการคลาวด์ที่มักจะอัปเดตให้อัตโนมัติ

- อาจมีข้อจำกัดด้านความสามารถ: โมเดลที่รันบนเครื่องตัวเองอาจมีข้อจำกัดด้านความสามารถเมื่อเทียบกับโมเดลขนาดใหญ่ที่รันบนคลาวด์

- ต้องดูแลความปลอดภัยเอง: แม้จะปลอดภัยกว่าการส่งข้อมูลไปคลาวด์ แต่เราก็ต้องรับผิดชอบในการรักษาความปลอดภัยของระบบเองทั้งหมด

อย่างไรก็ตาม สำหรับองค์กรที่ให้ความสำคัญกับความเป็นส่วนตัวของข้อมูลเป็นอันดับแรก ข้อดีของ Ollama ก็น่าจะคุ้มค่ากับข้อจำกัดเหล่านี้ครับ

สรุป

Ollama เป็นแพลตฟอร์มที่น่าสนใจมากสำหรับการใช้งาน LLM แบบออฟไลน์ โดยเฉพาะสำหรับองค์กรที่ต้องการความปลอดภัยและความเป็นส่วนตัวสูง

จุดเด่นของ Ollama คือ:

- ทำงานบนเครื่องเราเอง ไม่ต้องพึ่งคลาวด์

- ประหยัดค่าใช้จ่าย

- ปรับแต่งได้ตามต้องการ

- รองรับการขยายตัวได้ดี

แม้จะมีข้อจำกัดบ้าง แต่สำหรับงานที่ต้องการความปลอดภัยสูง Ollama ก็น่าจะเป็นทางเลือกที่น่าสนใจมากครับ

💡 ความเห็นส่วนตัว: ผมคิดว่า Ollama เป็นก้าวสำคัญในการทำให้เทคโนโลยี AI เข้าถึงได้ง่ายขึ้นสำหรับองค์กรที่มีข้อจำกัดด้านความปลอดภัย การที่สามารถใช้งาน LLM โดยไม่ต้องพึ่งคลาวด์นั้นเป็นประโยชน์มากๆ โดยเฉพาะในยุคที่ความเป็นส่วนตัวของข้อมูลเป็นเรื่องสำคัญ

ถ้าคุณสนใจเรื่อง AI และการนำไปใช้งานจริง ผมแนะนำให้ลองศึกษาเพิ่มเติมเกี่ยวกับ เทคนิคการใช้งาน AI ต่างๆ ด้วยนะครับ จะช่วยให้เข้าใจภาพรวมของเทคโนโลยี AI ได้ดียิ่งขึ้น

สุดท้ายนี้ ถ้าใครมีคำถามหรือข้อสงสัยเพิ่มเติมเกี่ยวกับ Ollama หรือการใช้งาน LLM แบบออฟไลน์ ก็สามารถถามกันมาได้เลยนะครับ ยินดีแลกเปลี่ยนความรู้กันครับ 😊

#datascience #generativeai #genai #dataespresso

.