สวัสดีครับเพื่อนๆ ชาว Data-Espresso ทุกคน วันนี้ผมมีเรื่องสนุกๆ มาแชร์กัน นั่นก็คือวิธีการรัน LLM (Large Language Model) อย่าง DeepSeek-R1 บนคอมพิวเตอร์ส่วนตัวของเราเองครับ! 🖥️💪

หลายคนอาจจะสงสัยว่าทำไมเราถึงอยากรัน LLM บนเครื่องตัวเองล่ะ? คำตอบง่ายๆ เลยครับ มันเหมือนกับการมีซูเปอร์พาวเวอร์อยู่ในมือเราเลยนะ 555+

💡 ประโยชน์ของการรัน LLM บนเครื่องตัวเอง:

- ประหยัดค่าใช้จ่าย – ไม่ต้องจ่ายค่า API รายเดือน

- รักษาความเป็นส่วนตัว – ข้อมูลอยู่แค่ในเครื่องเรา ไม่ต้องส่งไปที่เซิร์ฟเวอร์ของใคร

- สนุกมาก! – ได้ทดลองเล่นกับ AI สุดล้ำได้แบบไม่มีขีดจำกัด

แต่ก่อนจะไปดูวิธีการกัน ผมขอแนะนำให้รู้จักกับ Large Language Models (LLMs) กันสักหน่อยนะครับ เผื่อใครยังไม่คุ้นเคย

เอาล่ะ มาดูกันเลยดีกว่าว่ามีวิธีไหนบ้างที่เราสามารถรัน LLM บนเครื่องตัวเองได้ 🚀

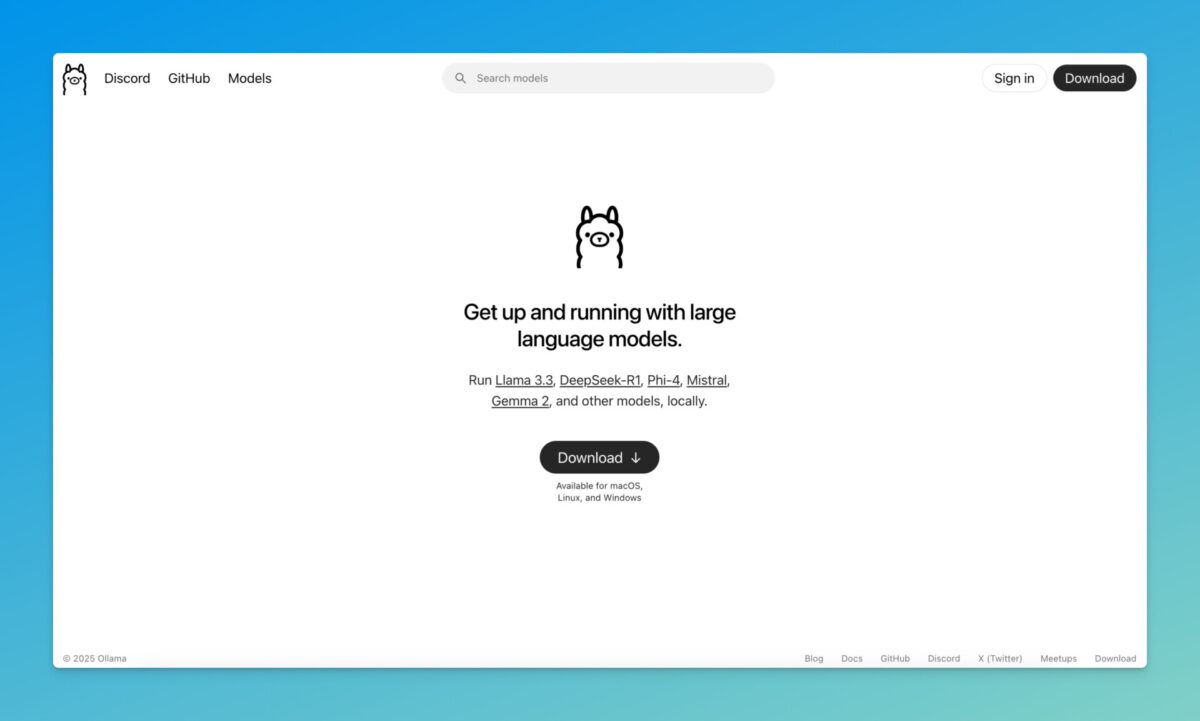

1. Ollama – ง่ายที่สุดสำหรับมือใหม่

Ollama เป็นเครื่องมือที่ใช้งานง่ายมากๆ ครับ เหมาะสำหรับมือใหม่ที่อยากลองเล่น LLM แต่ไม่อยากยุ่งยากกับการตั้งค่าอะไรมาก

วิธีใช้ก็ง่ายแสนง่าย หลังจากติดตั้งแล้วก็แค่พิมพ์คำสั่งเดียว:

ollama run deepseek-r1

แค่นี้ก็สามารถรัน DeepSeek-R1 บนเครื่องเราได้แล้ว! เจ๋งไหมล่ะ? 😎

ถ้ายังไม่มี Ollama ในเครื่อง ก็ติดตั้งได้ง่ายๆ ด้วยคำสั่งนี้:

curl -fsSL https://ollama.com/install.sh | sh

💡 ในความเห็นของผม Ollama เป็นตัวเลือกที่ดีที่สุดสำหรับคนที่เพิ่งเริ่มต้น เพราะใช้งานง่ายมาก แทบไม่ต้องตั้งค่าอะไรเลย

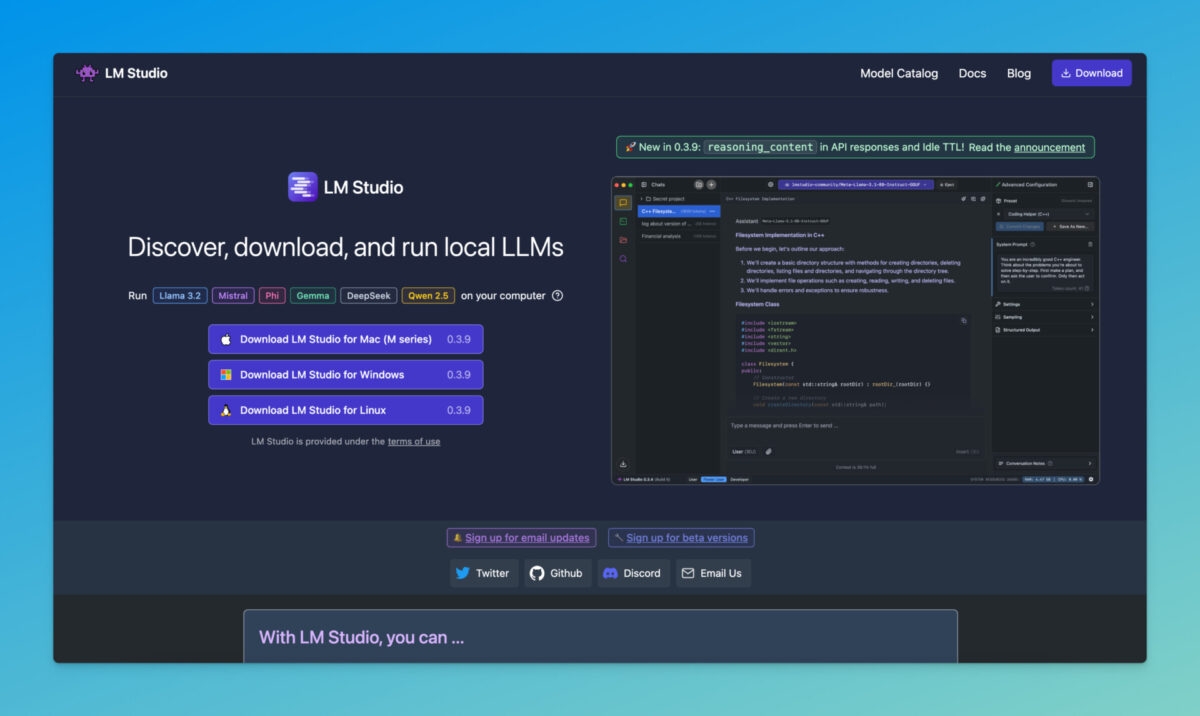

2. LMStudio – เหมือนใช้ ChatGPT บนเครื่องตัวเอง

LMStudio เป็นแอพที่ให้ประสบการณ์เหมือนกำลังใช้ ChatGPT บนเครื่องเราเองเลยครับ มีหน้าตา UI ที่คุ้นเคย ใช้งานง่าย

จุดเด่นของ LMStudio คือ:

- มีหน้าตาเหมือน ChatGPT ที่เราคุ้นเคย

- สามารถโหลดและเปลี่ยนโมเดลได้ง่ายๆ เหมือนเปลี่ยนเทปในเครื่องเล่นเทป

💡 ถ้าคุณชอบความคุ้นเคยของ ChatGPT แต่อยากใช้งานบนเครื่องตัวเอง LMStudio น่าจะเป็นตัวเลือกที่ดีครับ

3. vLLM – เร็วแรงแซงทางโค้ง

vLLM เป็นไลบรารี่ที่ออกแบบมาเพื่อการ inference และ serving ของ LLM โดยเฉพาะ จุดเด่นคือความเร็วในการประมวลผลที่สูงมาก

ข้อดีของ vLLM:

- ความเร็วในการ serving สูงมาก ⚡️

- สามารถใช้เป็น OpenAI compatible server ได้ด้วยโค้ดไม่กี่บรรทัด

💡 สำหรับคนที่ต้องการความเร็วสูงและมีทักษะการเขียนโค้ดอยู่บ้าง vLLM น่าจะเป็นตัวเลือกที่ดีครับ

4. LlamaCPP – ตำนานรุ่นแรก

LlamaCPP เป็นเครื่องมือรุ่นแรกๆ ที่ทำให้เราสามารถรัน LLM บนเครื่องตัวเองได้ พัฒนาโดย Georgi Gerganov

จุดเด่นของ LlamaCPP:

- ใช้ทรัพยากรน้อย

- มีประสิทธิภาพสูงมาก

- เหมาะสำหรับคนที่มีความรู้ด้านเทคนิคและต้องการปรับแต่งการทำงานในระดับลึก

💡 ถ้าคุณเป็นนักพัฒนาที่ต้องการความยืดหยุ่นสูงและไม่กลัวการตั้งค่าที่ซับซ้อน LlamaCPP อาจเป็นตัวเลือกที่ดีครับ

สรุป

เห็นไหมครับว่าการรัน LLM บนเครื่องตัวเองนั้นไม่ได้ยากอย่างที่คิด มีหลายวิธีให้เลือกตามความถนัดและความต้องการของแต่ละคน

- Ollama: เหมาะสำหรับมือใหม่ ใช้งานง่ายที่สุด

- LMStudio: เหมาะสำหรับคนที่ชอบ UI แบบ ChatGPT

- vLLM: เหมาะสำหรับคนที่ต้องการความเร็วสูงและมีทักษะการเขียนโค้ด

- LlamaCPP: เหมาะสำหรับนักพัฒนาที่ต้องการปรับแต่งการทำงานในระดับลึก

💡 ในความเห็นของผม การรัน LLM บนเครื่องตัวเองเป็นก้าวสำคัญในการเรียนรู้และทดลองกับ AI ครับ นอกจากจะได้ความรู้แล้ว ยังสนุกมากๆ ด้วย!

แล้วคุณล่ะครับ เคยลองรัน LLM บนเครื่องตัวเองหรือยัง? ถ้ายังก็ลองดูนะครับ รับรองว่าสนุกแน่นอน! 😄

#LLM #AI #LocalAI #MachineLearning

อ้างอิง: LinkedIn Post โดย Akshay Pachaar

P.S. ถ้าสนใจอยากรู้เพิ่มเติมว่าเราจะนำ LLM ไปใช้ในธุรกิจได้อย่างไร ลองอ่านบทความนี้ดูนะครับ มีตัวอย่างที่น่าสนใจมากๆ เลย!

#datascience #generativeai #genai #dataespresso

.