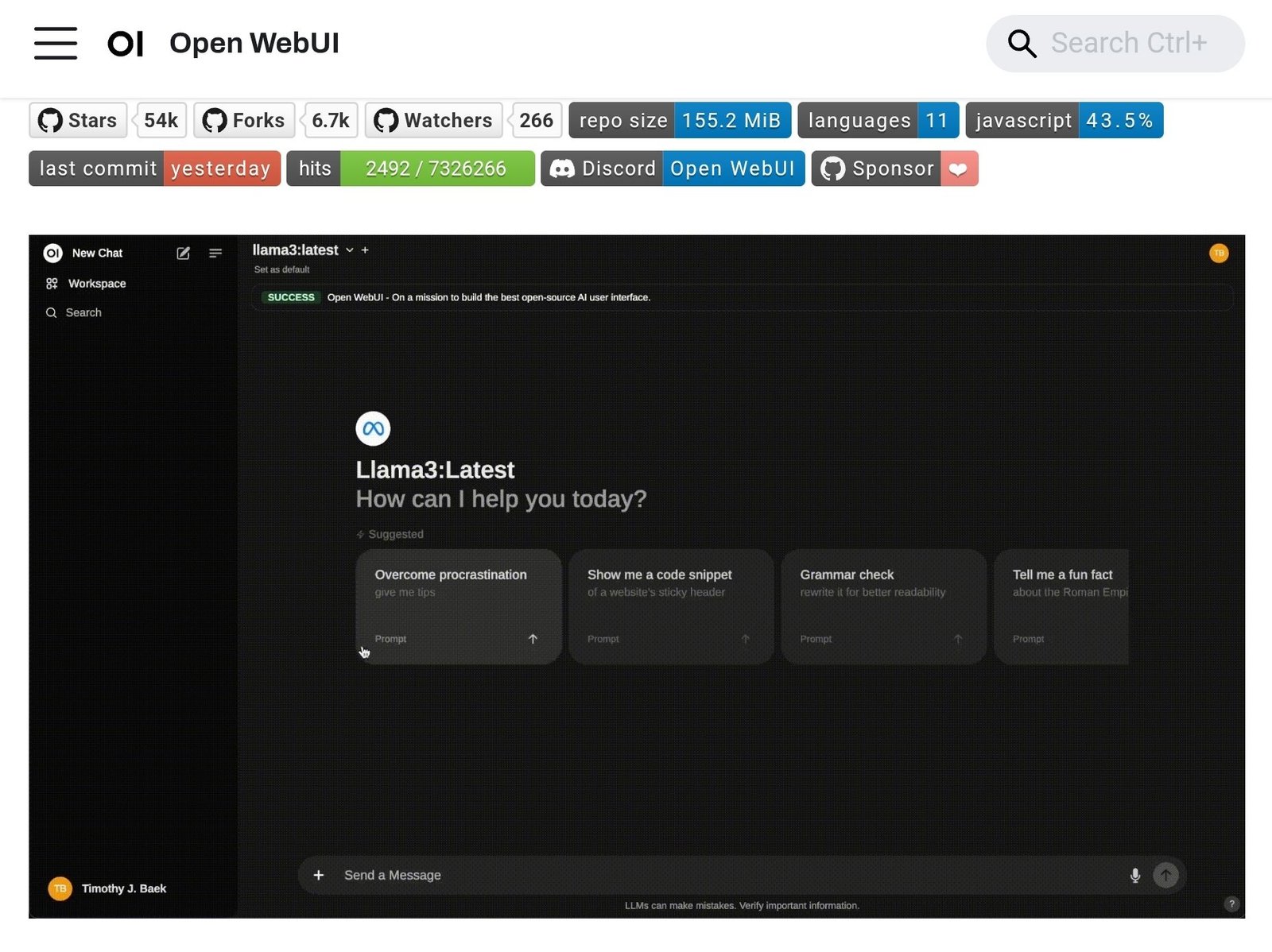

สวัสดีครับเพื่อน ๆ ชาว Data Espresso ทุกคน 👋 วันนี้ผมจะมาแนะนำ Open WebUI ให้รู้จักกันครับ

Open WebUI คืออะไร? 🤔

Open WebUI เป็น Web UI แบบ self-hosted สำหรับใช้งาน AI ที่มาพร้อมกับฟีเจอร์ครบครัน ใช้งานง่าย และสามารถขยายการทำงานได้ ที่สำคัญคือสามารถทำงานได้แบบ offline 100% เลยครับ

Open WebUI รองรับการทำงานกับ LLM runner หลายตัว ไม่ว่าจะเป็น Ollama หรือ API ที่เข้ากันได้กับ OpenAI ครับ

💡 ในความเห็นของผม Open WebUI น่าจะเป็นทางเลือกที่ดีสำหรับคนที่อยากลองเล่น AI แบบ self-hosted นะครับ เพราะติดตั้งง่าย ใช้งานสะดวก และมีฟีเจอร์ครบครัน

มาดูฟีเจอร์เด่น ๆ ของ Open WebUI กันครับ

ฟีเจอร์เด่นของ Open WebUI

1. ติดตั้งง่ายด้วย Docker หรือ Kubernetes 🐳

Open WebUI สามารถติดตั้งได้ง่าย ๆ ผ่าน Docker หรือ Kubernetes (kubectl, kustomize หรือ helm) ครับ รองรับทั้ง image แบบ :ollama และ :cuda

2. รองรับการใช้งานกับ Ollama และ OpenAI API 🤝

นอกจาก Ollama แล้ว Open WebUI ยังรองรับการใช้งานกับ API ที่เข้ากันได้กับ OpenAI ด้วยครับ สามารถปรับแต่ง URL ของ API ให้ใช้งานกับ LMStudio, GroqCloud, Mistral, OpenRouter และอื่น ๆ ได้

3. ระบบสิทธิ์และกลุ่มผู้ใช้แบบละเอียด 🛡️

ผู้ดูแลระบบสามารถกำหนดบทบาทและสิทธิ์ของผู้ใช้ได้อย่างละเอียด ทำให้มั่นใจได้ว่าระบบมีความปลอดภัย

4. ออกแบบ UI แบบ Responsive 📱

ใช้งานได้สะดวกทั้งบน Desktop, Laptop และมือถือครับ

5. รองรับการใช้งานแบบ Progressive Web App (PWA) บนมือถือ 📱

สามารถใช้งานได้เหมือนแอพเนทีฟบนมือถือ ใช้งาน offline ได้บน localhost และมี UI ที่ใช้งานง่าย

6. รองรับ Markdown และ LaTeX เต็มรูปแบบ ✒️🔢

สามารถใช้ Markdown และ LaTeX ได้อย่างเต็มที่ ทำให้โต้ตอบกับ LLM ได้อย่างสมบูรณ์แบบ

7. รองรับการโทรแบบ Voice/Video แบบ Hands-free 🎤📹

มีฟีเจอร์โทรด้วยเสียงและวิดีโอแบบ hands-free ในตัว ทำให้สามารถแชทได้อย่างสะดวกและโต้ตอบได้เป็นธรรมชาติมากขึ้น

8. สร้างโมเดลได้ง่ายด้วย Model Builder 🛠️

สามารถสร้างโมเดล Ollama ผ่าน Web UI ได้เลย สร้างและเพิ่ม character/agent แบบกำหนดเอง ปรับแต่งองค์ประกอบของการแชท และนำเข้าโมเดลได้ง่าย ๆ ผ่านการรวมกับ Open WebUI Community

9. รองรับ Python Function Calling แบบ Native 🐍

มี code editor ในตัวสำหรับเขียนฟังก์ชัน Python เพื่อใช้งานกับ LLM ได้ สามารถเพิ่มฟังก์ชัน Python ของตัวเองเข้าไปใช้งานได้ง่าย ๆ

10. รองรับ Local RAG (Retrieval Augmented Generation) 📚

สามารถโหลดเอกสารเข้าไปในแชทได้โดยตรง หรือเพิ่มไฟล์เข้าไปใน document library แล้วเรียกใช้งานได้ด้วยคำสั่ง # ก่อนข้อความที่ต้องการค้นหา

11. ค้นหาเว็บสำหรับ RAG 🔍

สามารถค้นหาเว็บโดยใช้บริการต่าง ๆ เช่น SearXNG, Google PSE, Brave Search, serpstack, serper, Serply, DuckDuckGo, TavilySearch, SearchApi และ Bing แล้วนำผลลัพธ์มาใช้ในการแชทได้โดยตรง

12. เรียกดูเว็บได้ 🌐

สามารถเรียกดูเว็บไซต์ในการแชทได้โดยใช้คำสั่ง # ตามด้วย URL ทำให้สามารถนำเนื้อหาจากเว็บมาใช้ในการสนทนาได้

13. สร้างภาพได้ 🎨

รองรับการสร้างภาพด้วย AUTOMATIC1111 API หรือ ComfyUI (แบบ local) และ OpenAI’s DALL-E (แบบ external) ทำให้สามารถสร้างภาพในระหว่างการแชทได้

14. คุยกับหลายโมเดลพร้อมกัน ⚙️

สามารถคุยกับหลาย ๆ โมเดลพร้อมกันได้ ทำให้ได้คำตอบที่หลากหลายและเลือกใช้จุดเด่นของแต่ละโมเดลได้

15. ระบบควบคุมการเข้าถึงแบบ Role-Based (RBAC) 🔐

กำหนดสิทธิ์การเข้าถึงได้ละเอียด เช่น จำกัดการเข้าถึง Ollama เฉพาะผู้ที่ได้รับอนุญาต และให้สิทธิ์สร้าง/ดึงโมเดลเฉพาะผู้ดูแลระบบ

16. รองรับหลายภาษา 🌐🌍

รองรับการใช้งานหลายภาษาผ่านระบบ internationalization (i18n) กำลังมองหาผู้ช่วยแปลภาษาเพิ่มเติมด้วยนะครับ

17. รองรับ Pipelines และ Plugin 🧩

สามารถเพิ่มโลจิกและใช้ไลบรารี Python กับ Open WebUI ได้ผ่าน Pipelines Plugin Framework สามารถทำอะไรได้หลากหลาย เช่น Function Calling, จำกัดการใช้งานของผู้ใช้, ติดตามการใช้งานด้วย Langfuse, แปลภาษาแบบ real-time ด้วย LibreTranslate, กรองข้อความที่ไม่เหมาะสม และอื่น ๆ อีกมากมาย

18. อัพเดทต่อเนื่อง 🌟

ทีมพัฒนามุ่งมั่นที่จะพัฒนา Open WebUI อย่างต่อเนื่อง ทั้งแก้บั๊ก ปรับปรุง และเพิ่มฟีเจอร์ใหม่ ๆ

💡 จากประสบการณ์ส่วนตัว ผมว่า Open WebUI มีฟีเจอร์ที่ครบถ้วนมากสำหรับการใช้งาน AI แบบ self-hosted เลยครับ โดยเฉพาะฟีเจอร์ Local RAG ที่ช่วยให้เราสามารถใช้งาน AI กับข้อมูลส่วนตัวได้อย่างปลอดภัย

วิธีติดตั้ง Open WebUI

มีหลายวิธีในการติดตั้ง Open WebUI ครับ วันนี้ผมจะแนะนำวิธีที่ง่ายที่สุดก่อนนะครับ นั่นคือการติดตั้งผ่าน Docker

ติดตั้งด้วย Docker 🐳

- ถ้าคุณใช้ Ollama บนเครื่องเดียวกัน ให้รันคำสั่งนี้:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main- ถ้า Ollama อยู่บนเซิร์ฟเวอร์อื่น ให้เปลี่ยน OLLAMA_BASE_URL เป็น URL ของเซิร์ฟเวอร์นั้น:

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main- ถ้าต้องการใช้ GPU ให้รันคำสั่งนี้:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda- ถ้าใช้แค่ OpenAI API อย่างเดียว ให้รันคำสั่งนี้:

docker run -d -p 3000:8080 -e OPENAI_API_KEY=your_secret_key -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main💡 Tips: อย่าลืมเปลี่ยน your_secret_key เป็น API key จริง ๆ ของคุณนะครับ

หลังจากรันคำสั่งเสร็จ คุณสามารถเข้าใช้งาน Open WebUI ได้ที่ http://localhost:3000 เลยครับ

ติดตั้ง Open WebUI พร้อม Ollama ในคอนเทนเนอร์เดียว

ถ้าคุณต้องการติดตั้ง Open WebUI พร้อมกับ Ollama ในคอนเทนเนอร์เดียวเลย ก็ทำได้ครับ

- สำหรับเครื่องที่มี GPU:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama- สำหรับเครื่องที่ไม่มี GPU:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama💡 จากประสบการณ์ส่วนตัว ผมแนะนำให้ใช้วิธีนี้ถ้าคุณยังไม่มี Ollama อยู่แล้ว เพราะจะได้ทั้ง Open WebUI และ Ollama พร้อมกันเลย สะดวกดีครับ

การแก้ปัญหาเบื้องต้น

ถ้าคุณเจอปัญหาการเชื่อมต่อ มักจะเกิดจากคอนเทนเนอร์ของ WebUI ไม่สามารถเข้าถึง Ollama server ที่ 127.0.0.1:11434 (host.docker.internal:11434) ได้

ลองใช้ flag –network=host ในคำสั่ง docker run ดูครับ แต่ต้องเปลี่ยน port จาก 3000 เป็น 8080 นะครับ

ตัวอย่างคำสั่ง:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:mainสรุป

Open WebUI เป็น Web UI สำหรับใช้งาน AI แบบ self-hosted ที่น่าสนใจมากครับ มีฟีเจอร์ครบครัน ติดตั้งง่าย และใช้งานสะดวก เหมาะสำหรับคนที่อยากลองเล่น AI แบบ self-hosted หรือองค์กรที่ต้องการควบคุมความปลอดภัยของข้อมูล

ถ้าคุณสนใจอยากลองใช้งาน Open WebUI ลองติดตั้งตามวิธีที่ผมแนะนำดูนะครับ หรือถ้ามีข้อสงสัยอะไรเพิ่มเติม สามารถถามในคอมเมนต์ได้เลยครับ 😄

#OpenWebUI #AI #SelfHosted #Docker

อ้างอิง: Open WebUI GitHub

อย่าลืมติดตาม Data Espresso เพื่อรับข่าวสารและเทคนิคเกี่ยวกับ AI และ Data อัพเดทใหม่ ๆ กันนะครับ 👋

#datascience #generativeai #genai #dataespresso

.