สวัสดีครับเพื่อนๆ ชาว Data-Espresso ทุกคน วันนี้เรามาทำความรู้จักกับโมเดล AI ตัวใหม่ล่าสุดจาก Microsoft กันดีกว่า นั่นก็คือ Phi-4 ที่มาพร้อมกับความสามารถสุดล้ำ แถมยังเป็น open model อีกด้วย เรียกได้ว่าน่าสนใจสุดๆ เลยทีเดียว มาดูกันเลยดีกว่าว่า Phi-4 มีอะไรเด็ดๆ บ้าง!

Phi-4 คืออะไร?

Phi-4 เป็นโมเดลภาษาขนาดใหญ่ (Large Language Model หรือ LLM) ที่มีขนาด 14B พารามิเตอร์ พัฒนาโดย Microsoft โดยเป็นโมเดลแบบ open source ที่เปิดให้นักพัฒนาและนักวิจัยสามารถนำไปใช้งานและต่อยอดได้

โมเดลนี้ถูกสร้างขึ้นจากการผสมผสานข้อมูลหลายประเภท ทั้งข้อมูลสังเคราะห์ (synthetic data) ข้อมูลจากเว็บไซต์สาธารณะที่ผ่านการคัดกรอง รวมถึงข้อมูลจากหนังสือวิชาการและชุดข้อมูลคำถาม-คำตอบ

💡 ในความเห็นของผม การที่ Microsoft เลือกใช้ข้อมูลหลากหลายประเภทในการเทรนโมเดลนี้ เป็นการวางรากฐานที่ดีมากๆ ครับ เพราะจะทำให้โมเดลมีความรู้กว้างขวางและสามารถรับมือกับงานหลากหลายรูปแบบได้

จุดเด่นของ Phi-4

1. ประสิทธิภาพสูงในขนาดที่กะทัดรัด

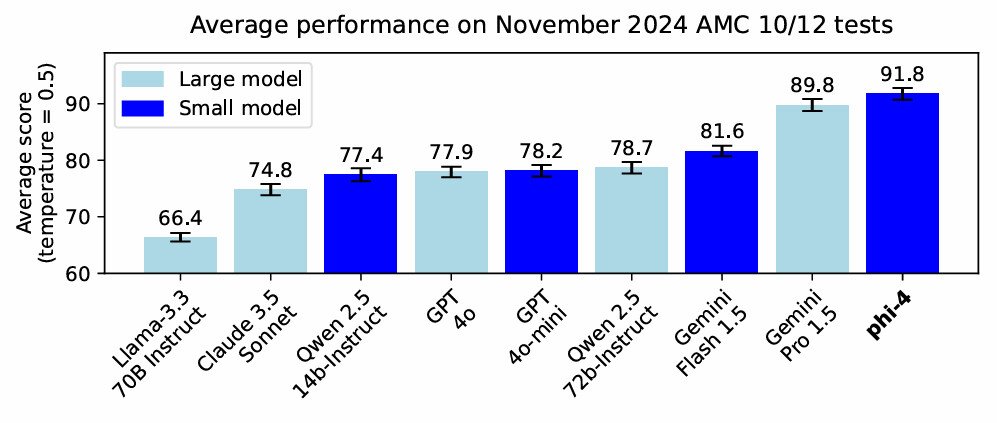

ถึงแม้ Phi-4 จะมีขนาด “แค่” 14B พารามิเตอร์ แต่ก็สามารถทำงานได้อย่างมีประสิทธิภาพสูงเทียบเท่ากับโมเดลขนาดใหญ่กว่าหลายเท่า เรียกได้ว่าเป็น “พลังแฝงในร่างเล็ก” เลยทีเดียว 555+

2. รองรับ Context ยาวถึง 16k tokens

Phi-4 สามารถรับ input ที่ยาวได้ถึง 16,000 tokens ซึ่งถือว่าเยอะมากๆ สำหรับโมเดลขนาดนี้ ทำให้สามารถรับมือกับงานที่ต้องการการวิเคราะห์ข้อมูลจำนวนมากได้อย่างสบายๆ

3. เน้นความปลอดภัยและการทำตามคำสั่ง

โมเดลนี้ผ่านกระบวนการ fine-tuning และ optimization อย่างเข้มข้น เพื่อให้มั่นใจว่าจะทำตามคำสั่งได้อย่างแม่นยำ และมีมาตรการด้านความปลอดภัยที่แข็งแกร่ง

💡 จากประสบการณ์ส่วนตัว ผมคิดว่าจุดนี้สำคัญมากๆ สำหรับการนำ AI ไปใช้งานจริง เพราะเราต้องการโมเดลที่ไม่เพียงแค่ฉลาด แต่ต้องปลอดภัยและควบคุมได้ด้วย

กรณีการใช้งานหลักของ Phi-4

Phi-4 ถูกออกแบบมาเพื่อเร่งการวิจัยด้าน language models และเป็นบล็อกพื้นฐานสำหรับการสร้างฟีเจอร์ AI แบบ generative โดยเหมาะกับการใช้งานในระบบ AI และแอปพลิเคชันทั่วไป (โดยเฉพาะภาษาอังกฤษ) ที่ต้องการ:

- สภาพแวดล้อมที่จำกัดด้าน Memory/Compute: เหมาะสำหรับการรันบนอุปกรณ์ที่มีทรัพยากรจำกัด

- สถานการณ์ที่ต้องการ Latency ต่ำ: ตอบสนองได้รวดเร็ว เหมาะกับงานที่ต้องการความเร็วสูง

- งานด้านการให้เหตุผลและตรรกะ: สามารถวิเคราะห์และแก้ปัญหาที่ซับซ้อนได้ดี

💡 ถ้าให้วิเคราะห์ ผมมองว่า Phi-4 น่าจะเหมาะมากสำหรับการพัฒนา แอปพลิเคชัน AI ที่ต้องทำงานแบบ real-time บนอุปกรณ์ที่มีข้อจำกัดด้านฮาร์ดแวร์ เช่น มือถือหรือ IoT devices ครับ

ข้อควรระวังในการใช้งาน

ถึงแม้ Phi-4 จะมีความสามารถสูง แต่ก็มีข้อควรระวังบางอย่างที่เราต้องคำนึงถึง:

ไม่ได้ออกแบบมาเพื่อทุกกรณีการใช้งาน: นักพัฒนาควรพิจารณาข้อจำกัดทั่วไปของ language models และประเมินความแม่นยำ ความปลอดภัย และความเป็นธรรมก่อนนำไปใช้ โดยเฉพาะในสถานการณ์ที่มีความเสี่ยงสูง

ต้องคำนึงถึงกฎหมายและข้อบังคับที่เกี่ยวข้อง: รวมถึงกฎหมายความเป็นส่วนตัว กฎหมายการค้า และอื่นๆ ที่เกี่ยวข้องกับการใช้งาน AI

เน้นภาษาอังกฤษเป็นหลัก: อาจมีข้อจำกัดในการใช้งานกับภาษาอื่นๆ

💡 ในฐานะนักพัฒนา เราต้องตระหนักเสมอว่า AI เป็นเครื่องมือที่ทรงพลัง แต่ก็มาพร้อมความรับผิดชอบ การใช้งานอย่างมีจริยธรรมและปลอดภัยควรเป็นสิ่งที่เราให้ความสำคัญเป็นอันดับแรกเสมอครับ

เปรียบเทียบกับโมเดลอื่นๆ

เมื่อเทียบกับโมเดลอื่นๆ ในขนาดและประเภทเดียวกัน Phi-4 มีจุดเด่นหลายอย่าง:

ประสิทธิภาพสูงในขนาดที่เล็กกว่า: เมื่อเทียบกับโมเดลขนาด 20B+ Phi-4 สามารถทำงานได้ใกล้เคียงหรือดีกว่าในบางกรณี ทั้งที่มีขนาดเล็กกว่า

การใช้ทรัพยากรที่มีประสิทธิภาพ: ด้วยขนาด 14B ทำให้ใช้ทรัพยากรน้อยกว่าโมเดลขนาดใหญ่ แต่ให้ผลลัพธ์ที่ดี

ความสามารถด้านการให้เหตุผล: Phi-4 มีความโดดเด่นในด้านการวิเคราะห์และให้เหตุผล ซึ่งเป็นจุดแข็งที่สำคัญ

💡 จากที่ได้ศึกษามา ผมมองว่า Phi-4 น่าจะเป็นตัวเลือกที่ดีมากสำหรับผู้ที่ต้องการความสมดุลระหว่างประสิทธิภาพและการใช้ทรัพยากร โดยเฉพาะสำหรับ startups หรือทีมวิจัยที่มีงบประมาณจำกัดครับ

การนำ Phi-4 ไปประยุกต์ใช้

ด้วยความสามารถที่หลากหลายของ Phi-4 เราสามารถนำไปประยุกต์ใช้ได้ในหลายด้าน เช่น:

Chat Assistant ที่ฉลาดและรวดเร็ว: สร้าง chatbot ที่สามารถโต้ตอบได้อย่างเป็นธรรมชาติและมีความรู้กว้างขวาง

เครื่องมือช่วยเขียน: พัฒนาแอปที่ช่วยในการเขียนบทความ รายงาน หรือแม้แต่โค้ดโปรแกรม

ระบบวิเคราะห์ข้อมูล: ใช้ในการวิเคราะห์ข้อมูลขนาดใหญ่ สรุปประเด็นสำคัญ และให้ insights ที่มีคุณค่า

- AI Assistant บนอุปกรณ์พกพา: ด้วยขนาดที่กะทัดรัด สามารถนำไปใช้บนสมาร์ทโฟนหรือแท็บเล็ตได้อย่างมีประสิทธิภาพ

💡 ผมคิดว่าหนึ่งในการประยุกต์ใช้ที่น่าสนใจมากๆ คือการนำ Phi-4 ไปใช้ใน ระบบ Ollama เพื่อสร้าง AI assistant ส่วนตัวที่ทรงพลังแต่ประหยัดทรัพยากร เหมาะสำหรับการใช้งานบน PC หรือ Mac ทั่วไปครับ

ทิศทางในอนาคตของ Phi-4

การเปิดตัวของ Phi-4 เป็นก้าวสำคัญในวงการ AI แต่นี่เป็นเพียงจุดเริ่มต้นเท่านั้น ในอนาคตเราอาจได้เห็น:

การพัฒนาโมเดลที่เล็กลงแต่ฉลาดขึ้น: เทคโนโลยีการ optimize โมเดลจะก้าวหน้าขึ้น ทำให้เราได้โมเดลที่เล็กลงแต่มีความสามารถสูงขึ้น

การรองรับภาษาที่หลากหลายมากขึ้น: อาจมีการ fine-tune Phi-4 ให้รองรับภาษาอื่นๆ นอกเหนือจากภาษาอังกฤษ

การบูรณาการกับเทคโนโลยีอื่นๆ: เช่น การผสานกับ computer vision หรือ speech recognition เพื่อสร้าง multimodal AI

💡 ผมเชื่อว่าในอีกไม่กี่ปีข้างหน้า เราจะได้เห็นการใช้งาน AI แบบ Phi-4 ในชีวิตประจำวันมากขึ้นเรื่อยๆ โดยที่เราอาจไม่รู้ตัวด้วยซ้ำว่ากำลังใช้งาน AI อยู่ เพราะมันจะกลายเป็นส่วนหนึ่งของเทคโนโลยีพื้นฐานไปแล้วครับ

สรุป

Phi-4 เป็นโมเดล AI ที่น่าจับตามองอย่างยิ่งในปี 2024 นี้ ด้วยความสามารถที่สูงในขนาดที่กะทัดรัด ทำให้เหมาะสำหรับการนำไปพัฒนาต่อยอดในหลากหลายด้าน ไม่ว่าจะเป็นการวิจัย การสร้างแอปพลิเคชัน หรือการพัฒนาระบบ AI ที่ต้องการประสิทธิภาพสูงแต่ใช้ทรัพยากรน้อย

อย่างไรก็ตาม เราต้องไม่ลืมคำนึงถึงข้อจำกัดและความรับผิดชอบในการใช้งาน AI เสมอ การใช้เทคโนโลยีอย่างมีจริยธรรมและปลอดภัยควรเป็นสิ่งที่เราให้ความสำคัญควบคู่ไปกับการพัฒนานวัตกรรมเสมอ

สุดท้ายนี้ ผมหวังว่าบทความนี้จะช่วยให้เพื่อนๆ เข้าใจเกี่ยวกับ Phi-4 มากขึ้นนะครับ และถ้าใครสนใจจะลองเล่นกับ AI ตัวนี้ ก็สามารถหาข้อมูลเพิ่มเติมได้ผ่าน Ollama ได้ครับ ที่เราได้รวบรวมไว้ครับ

แล้วพบกันใหม่ในบทความหน้านะครับ ขอบคุณที่ติดตาม Data-Espresso ครับ! 👋

#AI #Microsoft #Phi4 #OpenSourceAI

#datascience #generativeai #genai #dataespresso

.